SERVICE|先端研究「Reliable AI」

人工知能(AI)で

安全・安心な社会作り

人工知能(AI)の安全性を検証します。

特許第7007529号

「人工知能システムの安全性検証システム、安全性検証方法、および安全性検証プログラム」

レジリエンス・エンジニアリングにおける安全分析のための手法である機能共鳴分析(FRAM:Functional Resonance Analysis Method)と、FRAMの妥当性を立証するSpecTRM-RL(SpecTRM Requirement Language)の組み合わせ(特許第7007529号)により、人工知能(AI)の安全性を立証いたします。

こんなお悩みを

解決します

-

自動走行や自動配送などの

先端技術の検証をしたい運送

自動車

IT

-

人工知能の安全を解析し

ブラックボックスを

排除したいIT

自動運転

アプリケーション

-

安全開発保証に関する

人材育成をしたいIT

アプリケーション

Flow 検証の流れ

「可視化」と「完全性/一貫性解析」

-

STEP 01

人工知能(AI)システムの可視化

FRAMを用いて、「人工知能がなぜ問題をうまく解けるのか」を明らかにします。

-

STEP 02

可視化した人工知能モデルの完全性/一貫性解析

SpecTRM-RLにより、人工知能システムを可視化したFRAMモデルの完全性解析および一貫性解析を行います。

人工知能(AI)システムの可視化

STEP 01

人工知能(AI)システムの可視化

FRAMを用いて、「人工知能がなぜ問題をうまく解けるのか」を明らかにします。

STEP 02

可視化した人工知能モデルの完全性/一貫性解析

SpecTRM-RLにより、人工知能システムを可視化したFRAMモデルの完全性解析および一貫性解析を行います。

FRAMを用いて、「人工知能がなぜ問題をうまく解けるのか」を明らかにすることからはじめます。

FRAMでは、機能間の関係性がどのような形で行われているかを図示化します。右下の図に示される6要素のいずれかを選ぶことが可能で、これにより、機能と機能が単に「関連している」ことを示すだけでなく、「AはBの前提条件となっている」「AはBに資源を供給する」「AはBに動作トリガーを与える」「AはBの制御条件を提供する」「AはBに時間制約を与える」など、豊富な意味を与えることができます。

| 分類 | 機能の6要素 | ||||

|---|---|---|---|---|---|

| 入力 | トリガー | Input | |||

| 事前条件 | Precondition | ||||

| 事後条件 | 出力値を連続的に変化させる条件 | 制御パラメータ | Control | ||

| 出力値を停止させる条件(枯渇により出力停止) | 空間条件 | 資源 | Resource | ||

| 時間的条件 | 時間制約 | Time | |||

| 出力 | Output | ||||

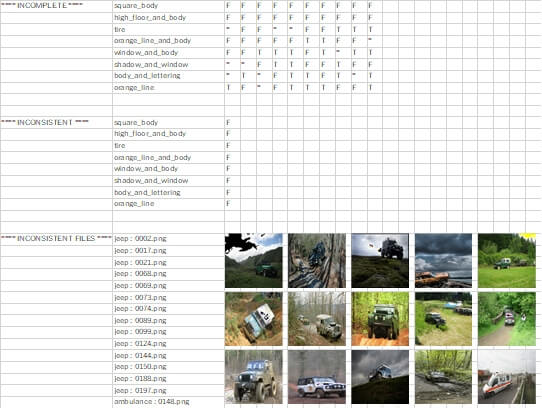

例えば、画像から乗用車とトラックを判定する人工知能を分析しようとする場合、同じことを自然知能がどのような内部論理構造に基づき判定しているのかをモデル化します。その際、判定に関わるパラメータにどのようなものであるかをやみくもに考えていては、漏れや間違いが発生しやすいですが、FRAMのモデリング手法に従い実施すると、網羅的に関連機能を識別できます。

具体的な例をあげると「荷台があり、屋根があり、長いノーズ部があれば、乗用車ではなくトラックである確率が高い」などです。

ここでの条件とは、「荷台があること」「屋根があること」、「長いノーズ部があること」を指しています。

可視化した人工知能モデルの完全性/一貫性解析

判定に関わる条件に不足がないか(例:トラックであることを判定するに必要な条件は他にないか)、複数の出力を出す同一の条件の組み合わせがないか(例:同じ条件でトラック以外と判定される可能性はないか)を解析します。

この繰り返しにより、可視化した人工知能(AI)システムモデルの完全性および一貫性の精度を向上させていきます。

検証手法はFRAMモデルで識別した条件を、LIMEやACEなどのXAI手法による根拠可視化の結果を基に修正します。さらに識別した条件に対して、SpecTRM-RLによって、人工知能システムを可視化したFRAMモデルの完全性解析および一貫性解析を行います。

人工知能(AI)システムの安全検証を行うことにより、ブラックボックスを可視化したうえで評価できるだけでなく、人間が思いつけなかった新しい論理を人工知能が学習の結果獲得したことを安全検証の結果知ることができるようになります。

人間は人工知能から学び、より良い安全のための新たな気づきを得ることができるようになります。人工知能の能力が人間を大きく凌駕した場合など、人工知能の挙動が理解できないという理由で安全性の立証をあきらめるのではなく、より積極的に、人工知能の成功要因を明らかにし、人間もそこから学び、ともに成長することが可能となることが期待されます。

異常検知/故障予兆検知AIモデルの安全性検証

本技術は画像以外のデータ分析に対しても適応可能です。

例えば故障予兆検知のAI/機械学習モデルの検知した根拠の可視化、モデルの信頼性評価等にも適応することができ、2019年より宇宙システムの実機テレメトリ

データを用いた実証を実施しておりま

す。

CONTACT

お問い合わせ

お問い合わせは

フォームにて受け付けております。

お気軽にご相談ください。

お急ぎの場合は、

お電話にてご相談ください。

有人宇宙システム株式会社 営業部

TEL:03-3211-2060

(平日午前10時~午後5時まで受付)